真鍋大度氏率いるsonicPlanetとTamatech Labが、自然言語でムービングライトをリアルタイム制御するAIツール「SPOTLIGHT AI」を共同開発した。

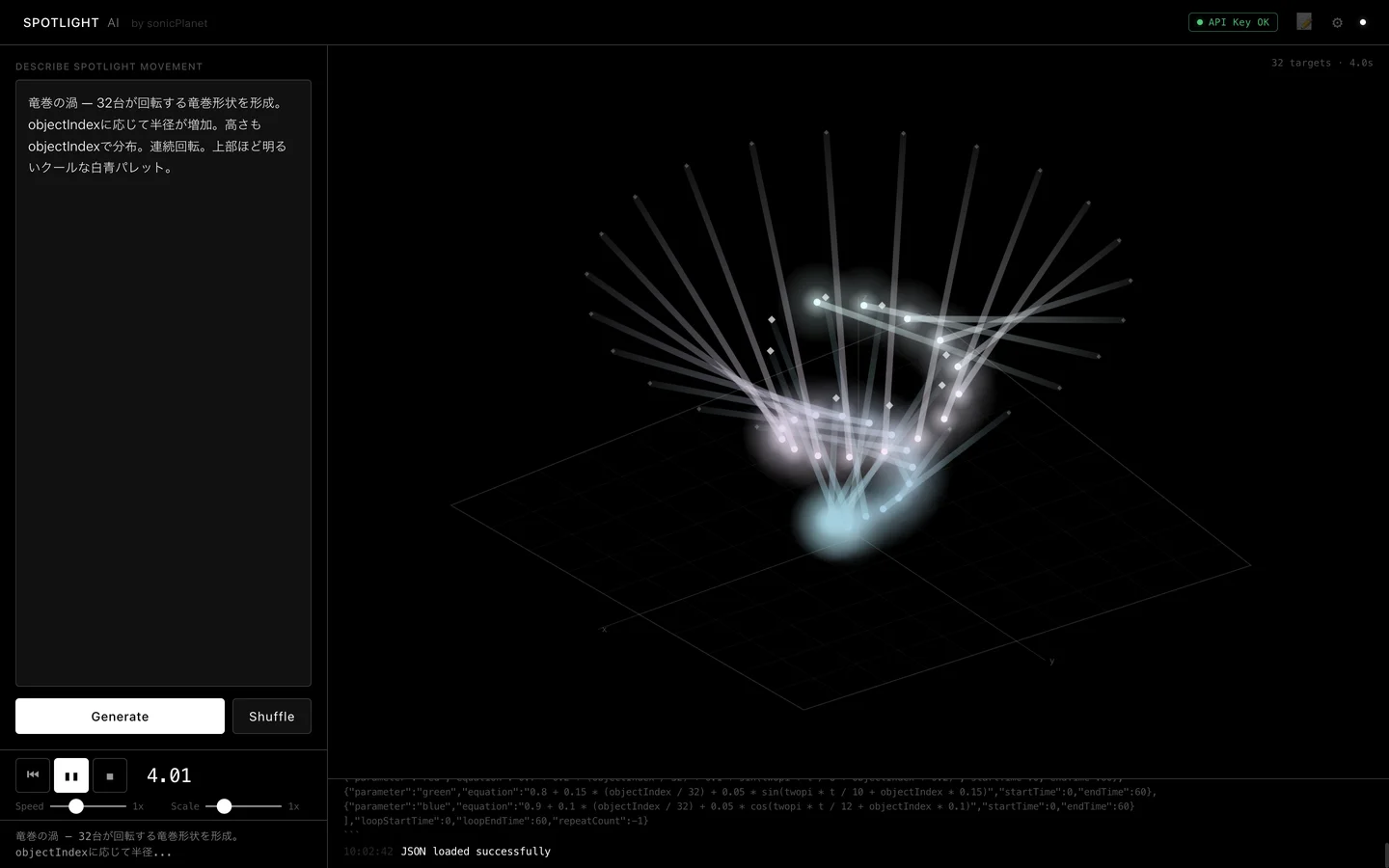

このツールは、ユーザーが日本語や英語で「オーロラのような光のカーテン」「ホタルの群れが漂う動き」などと入力するだけで、数秒後に照明パターンを生成する。画面の3Dプレビューで確認でき、実際のステージでも光が即座に動き出す。

操作は簡単だ。ブラウザ上でテキストを打ち、Generateボタンを押す。AIはAnthropicのClaudeモデルを使い、入力を位置や色の数式に変換する。三角関数やノイズ関数で連続的な動きを表現し、キーフレーム方式よりデータが少なくリアルタイム処理に適している。速度やスケールの調整もスライダーで可能であり、追加指示で再生成も一瞬である。

照明機器に制約はない。MA Lighting grandMA対応のあらゆる灯体で動作し、MartinやRobeなどのムービングライトからLEDバーまで使える。「ターゲットポイント」制御により、光の着地点の3D座標だけ指定すればよい。grandMAが自動でパン・チルトを計算する仕組みだ。

3つのプロトコル、OSC、PosiStageNet、Art-Net DMXを同時出力する。OSCはメディアアート向け、PosiStageNetは照明コンソール連携、Art-NetはDMX機器に最適である。これでインスタレーションからコンサートまで対応する。

300種類のプリセットも内蔵済みだ。「Spiral Galaxy」や「Fireflies」などのパターンをShuffleで即呼び出し、3Dビジュアライザーで360度確認できる。リモート操作も容易である。

照明デザインの参入障壁を下げる狙いがある。専門知識不要でアイデアを即形にし、クリエイターの試行錯誤を加速させる。デザイナーはプロトタイプを素早く作り、演出家は言葉でイメージを共有できる。

スタンドアロンで動作し、ダウンロードしてすぐ使う。短期的には音楽同期機能、長期的にはタイムライン管理を計画中だ。

本日2月18日から、東京ビッグサイトで開催中のProLight & ProVisual 2026、Tamatechブースで実機デモが行われている。20日まで続き、来場者はAI制御の光を体感できる。